Nu kan jag presentera ett delresultat av mitt SEO-experiment som handlade om duplicerat innehåll (duplicate content). Det jag testade var om det funkade med duplicate content på olika sajter, alltså inte inom samma sajt.

Det hela började med att jag lade upp exakt samma sajt, vid exakt samma tidpunkt, på två olika domäner. För att ge sajterna samma förutsättningar så länkade jag dem från samma ställen men med olika länktexter. Länktexterna har ingen betydelse i detta experiment då länkarna enbart skapades för att få sajterna indexerade. För jämlikhetens skull gjorde jag så att båda sajternas inlänkar placerades först på de länkande sidorna varsin gång. På ena sidan länkades först wki.se och sedan zxx.se. På den andra låg länkarna i omvänd ordning, zxx.se följt av wki.se.

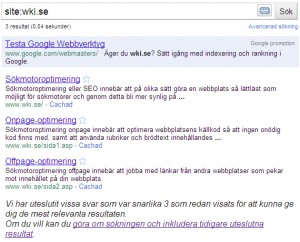

Vid första kontrollen den 26 februari gav en site-sökning följande resultat:

Här syns att samma sidor på båda sajterna är indexerade. Anledningen till att det är samma rubriker på de tre resultaten beror på mitt slarv. Jag ändrade senare title på undersidorna vid exakt samma tillfälle på båda sajterna.

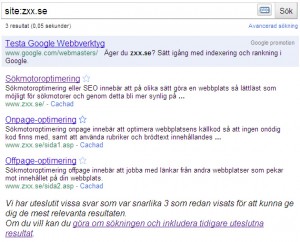

Vid en kontroll alldeles nyss (4 mars) gav en site-sökning följande resultat:

Nu har undersidorna fått sina nya titlar men det har dessutom dykt upp dubletter. Dessa är dubbelvisningar av startsida och någon av undersidorna. För startsidan är det med och utan avslutande snedstreck, men för undersidan är url:en exakt densamma på såväl utesluten som icke utesluten sida.

Nu är det ju inte så konstigt att båda sidorna syns på sina respektive site-sökningar. Det intressanta är ju om de kan visas under varandra på samma serp trots att de är identiska.

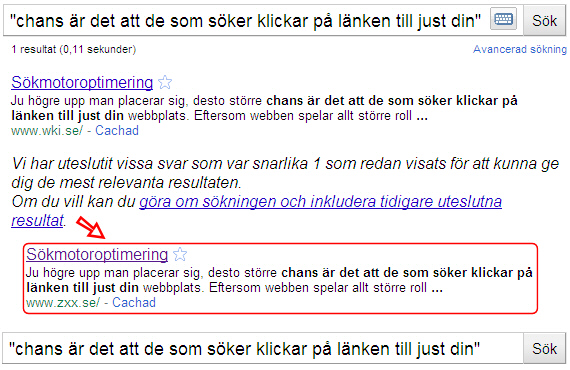

Det tittade jag också på under kvällen och upptäckte följande resultat för startsidan:

Skärmdumpar till fras-sökningar för undersidor hittas här och här.

Här har Google (antagligen helt slumpmässigt) valt ut wki.se som det mest relevanta resultatet och samtidigt förpassat zxx.se till sidan där man kan inkludera uteslutna resultat. De visas alltså inte på samma resultatsida eftersom Google anser att en av dem (zxx.se) är en dublett av den andra.

Nu är det inte så enkelt att jag kan utse wki.se till vinnare. Det spelar nämligen roll vilken fras man väljer att söka på, på såväl startsida som undersida. På vissa fraser visas wki.se medan zxx.se visas på andra. En annan intressant detalj ser ni på frassökningen för sida2. Där visas bara zxx.se i sökresultatet. Betyder det att Google är på G att plocka bort en av sajterna helt och hållet?

Det som däremot är säkert (i detta fall) är att båda sajterna aldrig visas tillsammans utan att man måste ”göra om sökningen och inkludera tidigare uteslutna resultat”.

Om jag inte förhastat mig i detta experiment så betyder detta att Google var väldigt snabb på att upptäcka och utesluta en av dem. Under denna tid har jag aldrig sett att de visades tillsammans. Nu fortsätter experimentet för att, om möjligt, få reda på vilka faktorer som triggar Google att se duplicerat innehåll.

Andra inlägg om detta experiment:

SEO-experiment: Duplicate content

SEO-experiment: Duplicate content (1)

SEO-experiment: Duplicate content (2)

SEO-experiment: Duplicate content (3)

Spännande experiment, blir intressant att se fortsättningen. :)

Det där med duplicate content är oerhört komplicerat, har själv försökt reda ut detta flera gånger. Ibland tror jag att jag förstår precis, för att sedan upptäcka att jag har haft totalt fel, då en annan sökning ger helt andra resultat. Så det ska bli mycket spännande att se vad du kommer fram till! :)

Intressant. Sitter själv med en handfull kundsajter där jag hela tiden argumenterar för att inte publicera duplicate content, även om det rör sig om två olika domäner med tydligt skillnad mellan bägge dvs mer än alternativ TLD.

Om kunderna gör det för att de vill återanvända samma texter för fler kommunikationskanaler och inte ser SEO:n i det hela så försök lösa det med canonical. http://www.seo-guide.se/canonical

De ser det antagligen som att använda samma annonstext i både DN och SvD. Inga problem m.a.o.

Som SEO:are ser man ju dock fördelen i att publicera indexerbart innehåll att kunna länka vidare från. Lyckas man inte övertyga kunderna om det, så är antagligen canonical det näst bästa alternativet.

OK, tack för tipset. Slog på några fraser på de berörda fraserna och G indexerar bägge just nu utan att lägga endera sajten som ”undantag” / dolt i standardsöket.

Låt säga att det i slutet av experimentet inte går att avgöra vilken faktor som styr resultatet, mer än slumpen… Varför inte då placera inlänkar till de olika sidorna med olika ankartexter, relaterade till två olika sökord, och sen se om dom rankar fast för olika sökord? Det borde fungera.

Kul att du gör tester och delar med dig av dina resultat. Själv har jag tänkt göra det väldigt många gånger men steget till att få tummen ur verkar tyvärr vara väldigt långt :(

Tackar, det är kul att du och andra visar intresse. Att hålla på och experimentera tar såklart tid från det vanliga optimeringsarbetet och underhållet. Man måste ju fokusera på det som är viktigast för stunden.